DeepSeek开源周收官,DeepSeek以最后一弹,再次在AI江湖激起了层层涟漪。

3月1日,DeepSeek在知乎上发表题为《DeepSeek-V3/R1 推理系统概览》的文章,全面揭晓V3/R1 推理系统背后的关键秘密。

最为引人注目的是,文章首次披露了DeepSeek的理论成本和利润率等关键信息。据介绍,假定GPU租赁成本为2美元/小时,总成本为87072美元/天;如果所有tokens全部按照DeepSeek R1的定价计算,理论上一天的总收入为562027美元/天,成本利润率为545%。

最大程度优化推理系统,理论成本利润率高达545%

据文章介绍,DeepSeek-V3/R1推理系统的优化目标是更大的吞吐、更低的延迟。为了实现这两个目标,DeepSeek使用了大规模跨节点专家并行(Expert Parallelism / EP)的方法,并通过一系列技术策略,最大程度地优化了大模型推理系统,实现了惊人的性能和效率。

具体而言,在更大的吞吐的方面,大规模跨节点专家并行能够使得batch size(批尺寸)大大增加,从而提高GPU矩阵乘法的效率,提高吞吐。

batch size在深度学习中是一个非常重要的超参数,指模型在训练过程中每次使用的数据量大小。它决定了每次模型更新时使用的训练样本数量,调整batch size可以影响模型的训练速度、内存消耗以及模型权重的更新方式。

在更低的延迟方面,大规模跨节点专家并行使得专家分散在不同的GPU上,每个GPU只需要计算很少的专家(因此更少的访存需求),从而降低延迟。

但是,由于大规模跨节点专家并行会大幅增加系统的复杂性,带来了跨节点通信、多节点数据并行、负载均衡等挑战,因此DeepSeek在文章中也重点论述了使用大规模跨节点专家并行增大batch size的同时,如何隐藏传输的耗时,如何进行负载均衡。

具体来看,DeepSeek团队主要通过规模化跨节点专家并行、双批次重叠策略、最优负载均衡等方式,最大化资源利用率,保证高性能和稳定性。

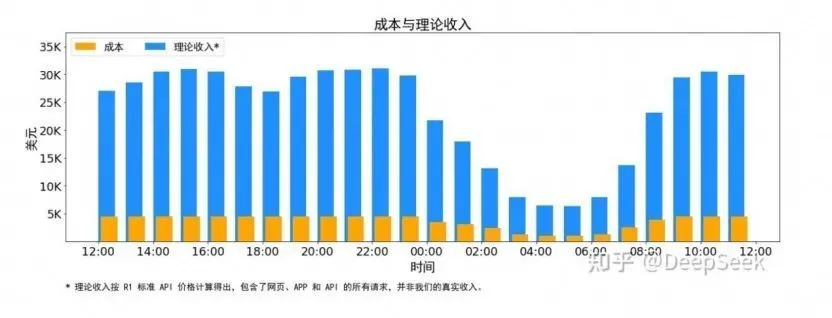

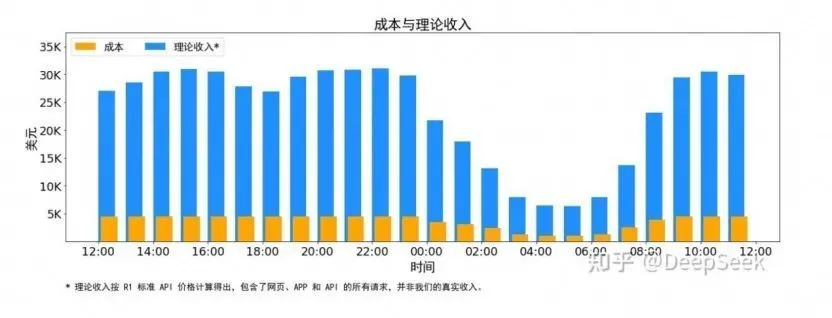

值得注意的是,文章还披露了DeepSeek的理论成本和利润率等关键信息。据介绍,DeepSeek V3 和R1的所有服务均使用英伟达的H800 GPU,由于白天的服务负荷高,晚上的服务负荷低,DeepSeek实现了一套机制,在白天负荷高的时候,用所有节点部署推理服务。晚上负荷低的时候,减少推理节点,以用来做研究和训练。

通过时间上的成本控制,DeepSeek表示DeepSeek V3和R1推理服务占用节点总和,峰值占用为278个节点,平均占用226.75个节点(每个节点为8个H800 GPU)。假定GPU租赁成本为2美元/小时,总成本为87072美元/天;如果所有tokens全部按照DeepSeek R1的定价计算,理论上一天的总收入为562027美元/天,成本利润率为545%。

不过,DeepSeek也强调,实际上的收入或许并没有那么多,因为V3的定价相较于R1要更低,另外夜间还会有折扣。记者注意到,2月26日,DeepSeek在其API开放平台发布错峰优惠活动通知。根据通知,北京时间每日00:30-08:30为错峰时段,API调用价格大幅下调,其中DeepSeek-V3降至原价的50%,DeepSeek-R1降至25%。DeepSeek鼓励用户在该时段调用,享受更经济更流畅的服务体验。

根据模型价格细节,在标准时段(北京时间08:30-00:30),V3和R1的百万tokens输入(缓存命中)价格分别为0.5元和1元,百万tokens输出分别为8元和16元,R1均为V3的两倍。而在优惠时段(北京时间00:30-08:30),V3和R1的百万tokens输入(缓存命中)则均降为0.25元,百万tokens输出均降为4元。

开源周告一段落,更多惊喜或许还在路上

随着最后一枚“重磅炸弹”的发布,DeepSeek的开源周活动正式告一段落。

在过去的一周里,DeepSeek每天开源一个代码库,堪称公开了一个“技术全家桶”。业内人士分析,这一系列的技术组件看似独立,实则共同构建成了一套精密协同的系统,让DeepSeek在有限算力之下最大程度地“榨干”了GPU,实现了训练推理效率的大幅提升。

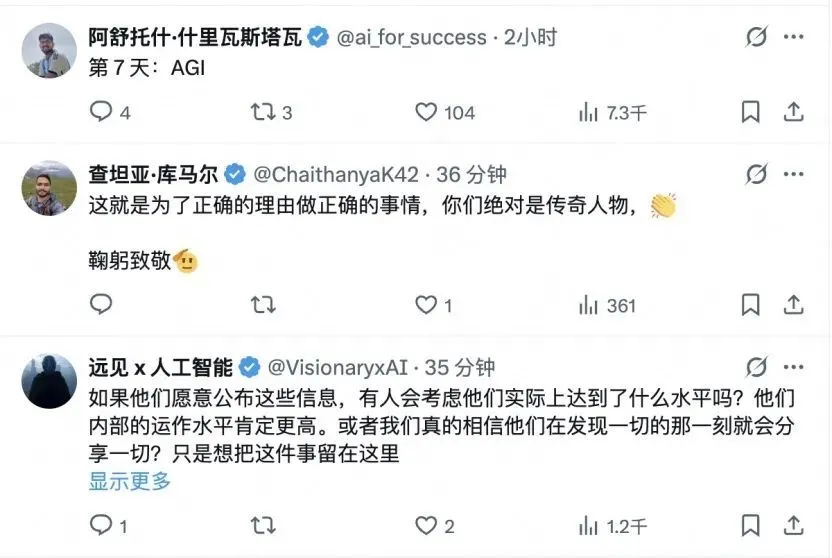

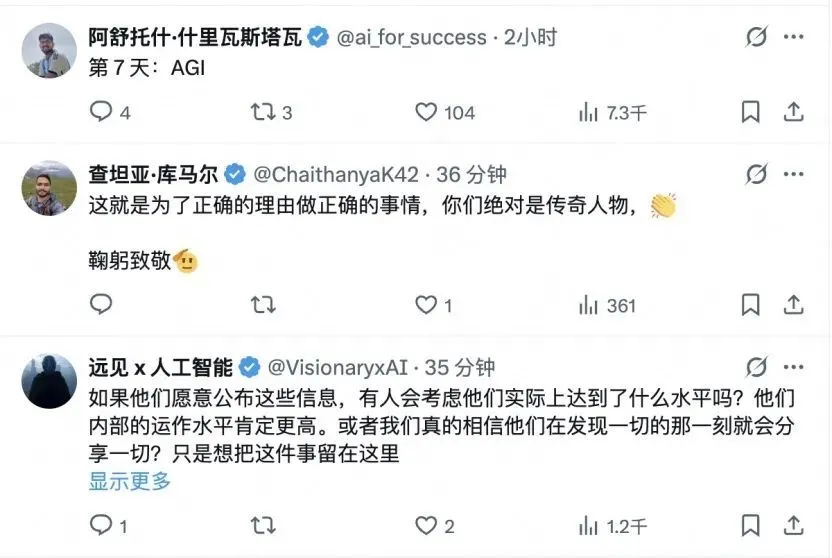

记者注意到,在DeepSeek今天发布“最后一弹”的帖子下,不少国外网友表达了赞叹。例如,一名网友表示,到第七天,DeepSeek或许还会发布AGI(通用人工智能,人工智能的最高目标);另外一名网友表示,“这就是为了正确的理由做正确的事情,你们绝对是传奇,鞠躬致敬”;还有网友猜测,DeepSeek愿意公布这些信息,说明他们实际上已经达到了领先的水平,实际的技术能力可能更高。

不仅如此,还有网友将DeepSeek与OpenAI进行对比,表示:“‘成本利润率545%’,等一下,所以你是说我被OpenAI抢劫了?”

与DeepSeek的开源、免费相比,OpenAI的模型收费一直十分昂贵。就在2月28日,OpenAI正式发布最新模型GPT-4.5研究预览版,这是一款号称“情商最高”的通用大语言模型。然而,其高达每100万tokens输入75美元的API调用价格,相比GPT-4o的2.5美元暴涨了30倍,相比DeepSeek的正常价格,GPT-4.5输入价格更是达到了惊人的280倍。

事实上,GPT-4.5发布后,许多网友已在评论区吐槽定价太贵。而OpenAI的CEO山姆·奥特曼也承认,GPT-4.5是一个“庞大且昂贵的模型”。“我们原本非常希望同时向Plus和Pro用户推出它,但随着我们的规模发展壮大,我们已经耗尽了GPU资源。我们将在下周增加数万块GPU,然后将其推出给Plus层级的用户。”奥特曼在其个人社交平台上表示。

作为大模型领域的“鲶鱼”,DeepSeek如同一名初出茅庐、聪明而锐气的年轻人,持续地给行业的老玩家及巨头们带来压力。最近,据外媒透露,DeepSeek正在加速研发DeepSeek-R2推理模型,这一模型原计划今年5月发布,但或许会提前,新模型有望可以生成更好的代码,并且使用英语之外的语言进行推理。

从V3到R1,再到即将面世的R2,外界对DeepSeek充满了期待,DeepSeek也以持续的技术突破惊艳世界。开源周虽然暂时结束了,但更多的惊喜,或许还在路上。

DeepSeek开源周收官,DeepSeek以最后一弹,再次在AI江湖激起了层层涟漪。

3月1日,DeepSeek在知乎上发表题为《DeepSeek-V3/R1 推理系统概览》的文章,全面揭晓V3/R1 推理系统背后的关键秘密。

最为引人注目的是,文章首次披露了DeepSeek的理论成本和利润率等关键信息。据介绍,假定GPU租赁成本为2美元/小时,总成本为87072美元/天;如果所有tokens全部按照DeepSeek R1的定价计算,理论上一天的总收入为562027美元/天,成本利润率为545%。

最大程度优化推理系统,理论成本利润率高达545%

据文章介绍,DeepSeek-V3/R1推理系统的优化目标是更大的吞吐、更低的延迟。为了实现这两个目标,DeepSeek使用了大规模跨节点专家并行(Expert Parallelism / EP)的方法,并通过一系列技术策略,最大程度地优化了大模型推理系统,实现了惊人的性能和效率。

具体而言,在更大的吞吐的方面,大规模跨节点专家并行能够使得batch size(批尺寸)大大增加,从而提高GPU矩阵乘法的效率,提高吞吐。

batch size在深度学习中是一个非常重要的超参数,指模型在训练过程中每次使用的数据量大小。它决定了每次模型更新时使用的训练样本数量,调整batch size可以影响模型的训练速度、内存消耗以及模型权重的更新方式。

在更低的延迟方面,大规模跨节点专家并行使得专家分散在不同的GPU上,每个GPU只需要计算很少的专家(因此更少的访存需求),从而降低延迟。

但是,由于大规模跨节点专家并行会大幅增加系统的复杂性,带来了跨节点通信、多节点数据并行、负载均衡等挑战,因此DeepSeek在文章中也重点论述了使用大规模跨节点专家并行增大batch size的同时,如何隐藏传输的耗时,如何进行负载均衡。

具体来看,DeepSeek团队主要通过规模化跨节点专家并行、双批次重叠策略、最优负载均衡等方式,最大化资源利用率,保证高性能和稳定性。

值得注意的是,文章还披露了DeepSeek的理论成本和利润率等关键信息。据介绍,DeepSeek V3 和R1的所有服务均使用英伟达的H800 GPU,由于白天的服务负荷高,晚上的服务负荷低,DeepSeek实现了一套机制,在白天负荷高的时候,用所有节点部署推理服务。晚上负荷低的时候,减少推理节点,以用来做研究和训练。

通过时间上的成本控制,DeepSeek表示DeepSeek V3和R1推理服务占用节点总和,峰值占用为278个节点,平均占用226.75个节点(每个节点为8个H800 GPU)。假定GPU租赁成本为2美元/小时,总成本为87072美元/天;如果所有tokens全部按照DeepSeek R1的定价计算,理论上一天的总收入为562027美元/天,成本利润率为545%。

不过,DeepSeek也强调,实际上的收入或许并没有那么多,因为V3的定价相较于R1要更低,另外夜间还会有折扣。记者注意到,2月26日,DeepSeek在其API开放平台发布错峰优惠活动通知。根据通知,北京时间每日00:30-08:30为错峰时段,API调用价格大幅下调,其中DeepSeek-V3降至原价的50%,DeepSeek-R1降至25%。DeepSeek鼓励用户在该时段调用,享受更经济更流畅的服务体验。

根据模型价格细节,在标准时段(北京时间08:30-00:30),V3和R1的百万tokens输入(缓存命中)价格分别为0.5元和1元,百万tokens输出分别为8元和16元,R1均为V3的两倍。而在优惠时段(北京时间00:30-08:30),V3和R1的百万tokens输入(缓存命中)则均降为0.25元,百万tokens输出均降为4元。

开源周告一段落,更多惊喜或许还在路上

随着最后一枚“重磅炸弹”的发布,DeepSeek的开源周活动正式告一段落。

在过去的一周里,DeepSeek每天开源一个代码库,堪称公开了一个“技术全家桶”。业内人士分析,这一系列的技术组件看似独立,实则共同构建成了一套精密协同的系统,让DeepSeek在有限算力之下最大程度地“榨干”了GPU,实现了训练推理效率的大幅提升。

记者注意到,在DeepSeek今天发布“最后一弹”的帖子下,不少国外网友表达了赞叹。例如,一名网友表示,到第七天,DeepSeek或许还会发布AGI(通用人工智能,人工智能的最高目标);另外一名网友表示,“这就是为了正确的理由做正确的事情,你们绝对是传奇,鞠躬致敬”;还有网友猜测,DeepSeek愿意公布这些信息,说明他们实际上已经达到了领先的水平,实际的技术能力可能更高。

不仅如此,还有网友将DeepSeek与OpenAI进行对比,表示:“‘成本利润率545%’,等一下,所以你是说我被OpenAI抢劫了?”

与DeepSeek的开源、免费相比,OpenAI的模型收费一直十分昂贵。就在2月28日,OpenAI正式发布最新模型GPT-4.5研究预览版,这是一款号称“情商最高”的通用大语言模型。然而,其高达每100万tokens输入75美元的API调用价格,相比GPT-4o的2.5美元暴涨了30倍,相比DeepSeek的正常价格,GPT-4.5输入价格更是达到了惊人的280倍。

事实上,GPT-4.5发布后,许多网友已在评论区吐槽定价太贵。而OpenAI的CEO山姆·奥特曼也承认,GPT-4.5是一个“庞大且昂贵的模型”。“我们原本非常希望同时向Plus和Pro用户推出它,但随着我们的规模发展壮大,我们已经耗尽了GPU资源。我们将在下周增加数万块GPU,然后将其推出给Plus层级的用户。”奥特曼在其个人社交平台上表示。

作为大模型领域的“鲶鱼”,DeepSeek如同一名初出茅庐、聪明而锐气的年轻人,持续地给行业的老玩家及巨头们带来压力。最近,据外媒透露,DeepSeek正在加速研发DeepSeek-R2推理模型,这一模型原计划今年5月发布,但或许会提前,新模型有望可以生成更好的代码,并且使用英语之外的语言进行推理。

从V3到R1,再到即将面世的R2,外界对DeepSeek充满了期待,DeepSeek也以持续的技术突破惊艳世界。开源周虽然暂时结束了,但更多的惊喜,或许还在路上。