华为布局AI(人工智能)领域迎来重要进展。

天眼查显示,近日,华为技术有限公司(以下统称华为)申请的“人工智能模型的量化方法、处理系统和量化单元”专利公布,可以减少AI模型占用的内存。

今年以来,华为公开的AI领域专利已达26项。2月5日,华为董事长梁华在广东省高质量发展大会上发言称,当前,AI技术正处于加速发展阶段,在千行百业的应用也迎来关键时期,抓住新机遇的关键是创新。

记者注意到,华为近期加大与DeepSeek的合作力度,包含华为ModelEngine支持DeepSeek全系列本地部署,DeepSeek系列新模型正式上线昇腾社区等。

华为重要AI专利公布

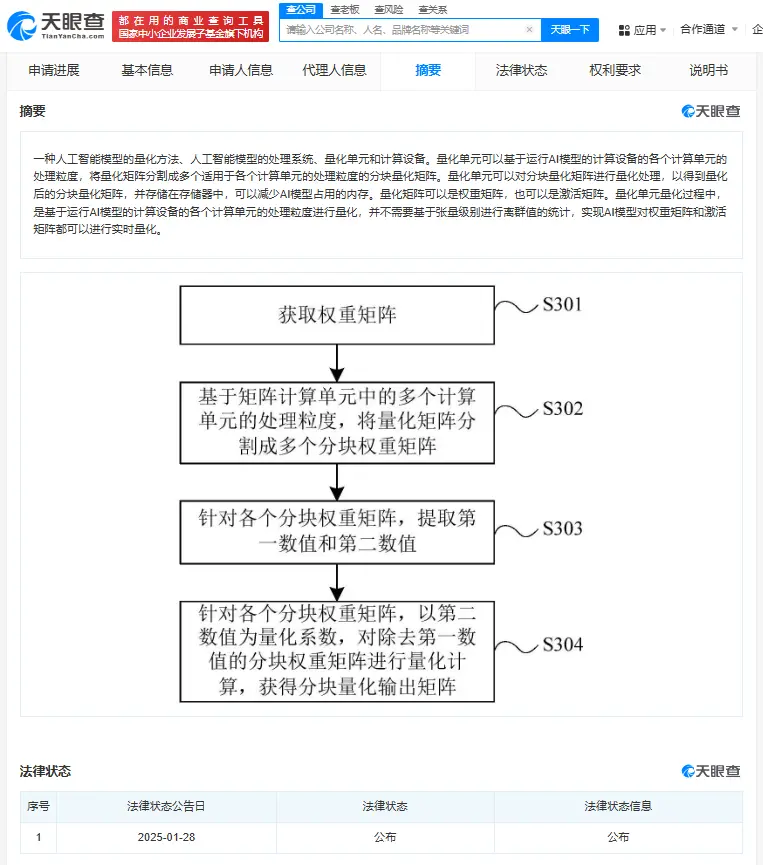

专利摘要显示,华为此次申请的专利涉及AI领域,尤其涉及一种AI模型的量化方法、AI模型的处理系统、量化单元和计算设备。

AI模型是利用数据和算法,对某一领域或任务中的问题进行建模和解决。目前,部分AI模型已经应用在机器翻译、问答系统、语音识别和文本生成等领域。

2月6日,华为中国发文称,在全球AI技术飞速发展的背景下,模型的快速迭代与高效部署成为各大科技企业竞相追逐的焦点。

不过,随着AI技术发展,相关AI模型的规模越来越大,存在参数量较大、占用内存较多等问题,导致计算复杂度不断提升。

为了解决上述问题,华为此次申请的专利提供了一种AI模型的量化方法。

专利摘要显示,量化单元可以基于运行AI模型的计算设备中各个计算单元的处理粒度,将量化矩阵分割成多个适用于各个计算单元处理粒度的分块量化矩阵。

量化单元可以对分块量化矩阵进行量化处理,从而得到量化后的分块量化矩阵,并存储在存储器中以减少AI模型占用的内存。

量化矩阵可以是权重矩阵,也可以是激活矩阵。量化单元在量化过程中,是基于运行AI模型的计算设备中各个计算单元的处理粒度进行量化,不需要基于张量级别进行离群值的统计,实现AI模型对权重矩阵和激活矩阵都可以进行实时量化。

华为与DeepSeek合作不断深入

2月6日,华为中国宣布,华为DCS AI全栈解决方案中的重要产品—ModelEngine,全面支持DeepSeek大模型R1&V3和蒸馏系列模型的本地部署与优化,加速客户AI应用快速落地。

据悉,ModelEngine作为大模型训练、推理和应用开发的AI平台,提供从数据预处理到模型训练、优化及部署的一站式服务。

华为中国介绍,用户通过ModelEngine可以体验DeepSeek的高效推理能力;开发者通过ModelEngine可实现对DeepSeek系列模型的“一键部署”,省去硬件选型、兼容性验证和环境配置等步骤,大幅降低企业AI应用门槛。

目前,华为旗下多个业务相继与DeepSeek开展合作。

2月5日,基于原生鸿蒙操作系统的小艺助手App接入DeepSeek-R1 Beta(公测)版。升级至原生鸿蒙的华为用户,可以通过“小艺助手App-发现-智能体广场”与DeepSeek对话。

2月4日,DeepSeek-R1、DeepSeek-V3、DeepSeek-V2、Janus-Pro正式上线昇腾社区,支持一键获取DeepSeek系列模型,支持昇腾硬件平台上开箱即用,推理快速部署,带来更快、更高效、更便捷的AI开发和应用体验。

公开资料显示,DeepSeek最新发布的多模态大模型Janus-Pro,以及之前发布的大型语言模型DeepSeek-R1、DeepSeek-V3及DeepSeek-V2,在AI领域引起热烈反响,多项技术提升了模型性能与效率。

华为布局AI(人工智能)领域迎来重要进展。

天眼查显示,近日,华为技术有限公司(以下统称华为)申请的“人工智能模型的量化方法、处理系统和量化单元”专利公布,可以减少AI模型占用的内存。

今年以来,华为公开的AI领域专利已达26项。2月5日,华为董事长梁华在广东省高质量发展大会上发言称,当前,AI技术正处于加速发展阶段,在千行百业的应用也迎来关键时期,抓住新机遇的关键是创新。

记者注意到,华为近期加大与DeepSeek的合作力度,包含华为ModelEngine支持DeepSeek全系列本地部署,DeepSeek系列新模型正式上线昇腾社区等。

华为重要AI专利公布

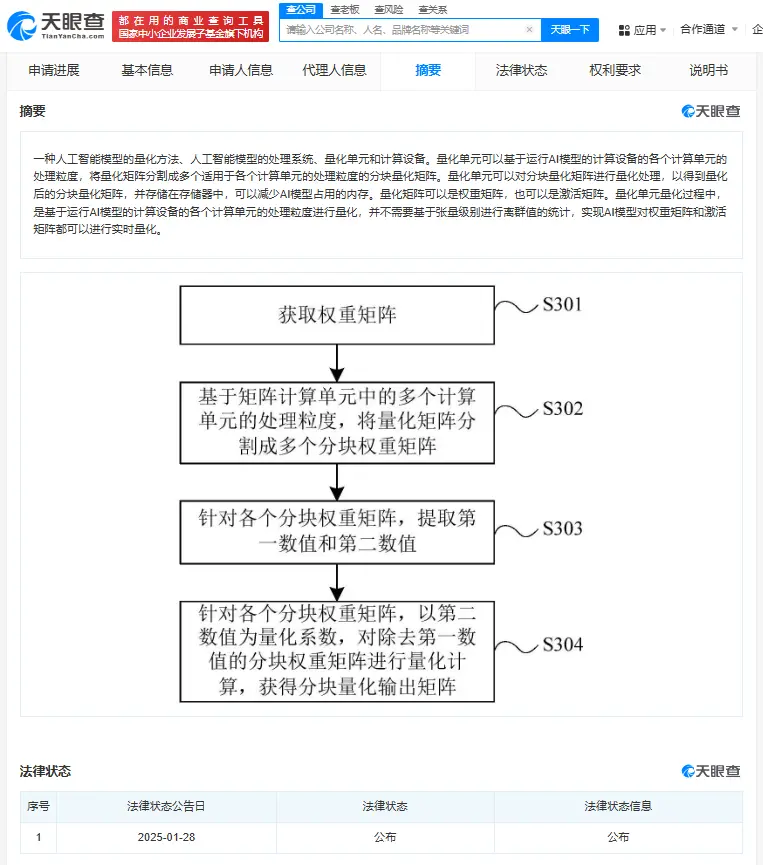

专利摘要显示,华为此次申请的专利涉及AI领域,尤其涉及一种AI模型的量化方法、AI模型的处理系统、量化单元和计算设备。

AI模型是利用数据和算法,对某一领域或任务中的问题进行建模和解决。目前,部分AI模型已经应用在机器翻译、问答系统、语音识别和文本生成等领域。

2月6日,华为中国发文称,在全球AI技术飞速发展的背景下,模型的快速迭代与高效部署成为各大科技企业竞相追逐的焦点。

不过,随着AI技术发展,相关AI模型的规模越来越大,存在参数量较大、占用内存较多等问题,导致计算复杂度不断提升。

为了解决上述问题,华为此次申请的专利提供了一种AI模型的量化方法。

专利摘要显示,量化单元可以基于运行AI模型的计算设备中各个计算单元的处理粒度,将量化矩阵分割成多个适用于各个计算单元处理粒度的分块量化矩阵。

量化单元可以对分块量化矩阵进行量化处理,从而得到量化后的分块量化矩阵,并存储在存储器中以减少AI模型占用的内存。

量化矩阵可以是权重矩阵,也可以是激活矩阵。量化单元在量化过程中,是基于运行AI模型的计算设备中各个计算单元的处理粒度进行量化,不需要基于张量级别进行离群值的统计,实现AI模型对权重矩阵和激活矩阵都可以进行实时量化。

华为与DeepSeek合作不断深入

2月6日,华为中国宣布,华为DCS AI全栈解决方案中的重要产品—ModelEngine,全面支持DeepSeek大模型R1&V3和蒸馏系列模型的本地部署与优化,加速客户AI应用快速落地。

据悉,ModelEngine作为大模型训练、推理和应用开发的AI平台,提供从数据预处理到模型训练、优化及部署的一站式服务。

华为中国介绍,用户通过ModelEngine可以体验DeepSeek的高效推理能力;开发者通过ModelEngine可实现对DeepSeek系列模型的“一键部署”,省去硬件选型、兼容性验证和环境配置等步骤,大幅降低企业AI应用门槛。

目前,华为旗下多个业务相继与DeepSeek开展合作。

2月5日,基于原生鸿蒙操作系统的小艺助手App接入DeepSeek-R1 Beta(公测)版。升级至原生鸿蒙的华为用户,可以通过“小艺助手App-发现-智能体广场”与DeepSeek对话。

2月4日,DeepSeek-R1、DeepSeek-V3、DeepSeek-V2、Janus-Pro正式上线昇腾社区,支持一键获取DeepSeek系列模型,支持昇腾硬件平台上开箱即用,推理快速部署,带来更快、更高效、更便捷的AI开发和应用体验。

公开资料显示,DeepSeek最新发布的多模态大模型Janus-Pro,以及之前发布的大型语言模型DeepSeek-R1、DeepSeek-V3及DeepSeek-V2,在AI领域引起热烈反响,多项技术提升了模型性能与效率。